- 2025-03-31 10:58:29 | v0.3.0

- 通讯社交 | 15.4M | 简体中文

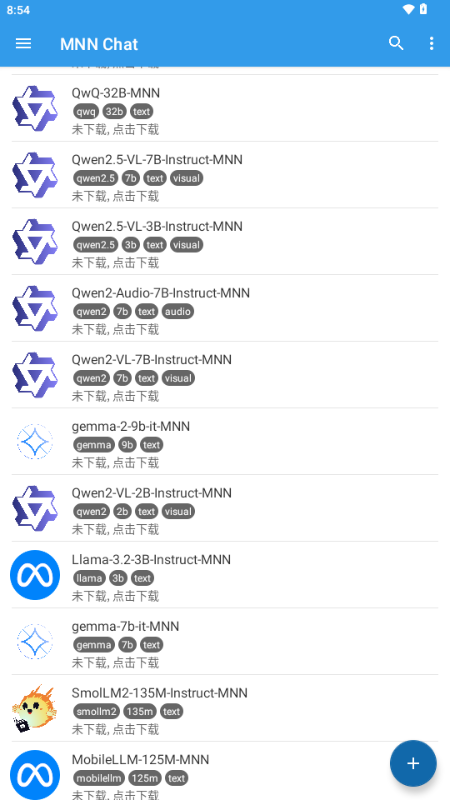

截图预览

MNN Chat手机大模型是一个使用手机跑本地大模型的软件,简单来说就是将AI部署在本地手机中,只要下载相应的大模型内容,然后导入,就可以在手机上使用各大厂商的大模型,包含deepseek R1满血版,通义QWQ等,这是一款老牌AI推理引擎工具。

MNN Chat手机大模型怎么使用

1、在本站下载MNN Chat手机大模型;

2、进入软件后,我们需要挑选我们想要部署的AI;

3、注意,这个本地部署至少要保留10GB以上的手机内存;

4、下载完成以后,就可以通过此软件与AI进行对话与聊天了;

5、支持多个语言,无限制词聊天,本地部署无需联网即可使用。

详细使用攻略可看文档:https://mnn-docs.readthedocs.io/en/latest/transformers/llm.html

MNN Chat是什么软件

MNN是一个轻量级的深度神经网络引擎,支持深度学习的推理与训练。适用于服务器/个人电脑/手机/嵌入式各类设备。目前,MNN已经在阿里巴巴的手机淘宝、手机天猫、优酷等30多个App中使用,覆盖直播、短视频、搜索推荐、商品图像搜索、互动营销、权益发放、安全风控等场景。

MNN-LLM是基于MNN引擎开发的大语言模型运行方案,解决大语言模型在本地设备的高效部署问题(手机/个人电脑/嵌入式设备)。支持常见的千问/百川/智谱/LLAMA等大语言模型。

软件功能

主体功能(模型推理CPU+GPU)无任何依赖,代码精简,可以方便地部署到移动设备和各种嵌入式设备中。

iOS平台:功能全开的MNN静态库 armv7+arm64大小12MB左右,链接生成可执行文件增加大小2M左右。可裁剪主体功能后静态库大小6.1M ,链接生成可执行文件增加大小 600 KB。

Android平台:主体功能 armv7a - c++_shared 动态库大小800KB左右。

支持采用 Mini 编辑选项进一步降低包大小,大约能在上述库体积基础上进一步降低 25% 左右。

支持模型FP16/Int8压缩与量化,可减少模型50% - 75% 的体积

通用性

支持 Tensorflow、Caffe、ONNX、Torchscripts 等主流模型文件格式,支持CNN / RNN / GAN / Transformer 等主流网络结构。

支持多输入多输出,支持任意维度的输入输出,支持动态输入(输入大小可变),支持带控制流的模型

算子丰富,支持 178 个Tensorflow Op、52个 Caffe Op、163个 Torchscipts Op、158 个 ONNX Op(ONNX 基本完整支持)

支持 服务器 / 个人电脑 / 手机 及具有POSIX接口的嵌入式设备,支持使用设备的 CPU / GPU 计算,支持部分设备的 NPU 计算(IOS 11 + CoreML / Huawei + HIAI / Android + NNAPI)

支持 Windows / iOS 8.0+ / Android 4.3+ / Linux 及具有POSIX接口的操作系统

软件亮点

对iOS / Android / PC / Server 的CPU架构进行了适配,编写SIMD代码或手写汇编以实现核心运算,充分发挥 CPU的算力,单线程下运行常见CV模型接近设备算力峰值

支持基于 Metal / OpenCL / Vulkan 使用移动端设备上的GPU进行推理

支持基于 CUDA 使用 PC / Server 上的 NVIDIA GPU 实现更快速的推理

广泛运用了 Winograd 卷积算法提升卷积性能,首次在业界工程实践中实现转置卷积的Winograd算法优化与矩阵乘的Strassen算法优化,并取得加速效果

支持低精度计算( int8 / fp16 / bf16)以提升推理性能。并对 ARMv8.2 和 AVX512架构的相关指令进行了适配,这两种架构下有更好的加速效果

支持使用 MNN 的算子进行常用的数值计算,覆盖 numpy 常用功能

提供 MNN CV 模块,支持图像仿射变换与归一化等 MNN_CV 库,支持常用的图像处理(armv7a 架构下小于 100 k )

支持各平台下的模型训练,尤其是移动端上的模型训练

支持 python 调用

更新日志

0.3.0

LLM 相关更新

App 发布

Android

新增Android的大模型应用(LLM / Diffusion),详见 apps/Android/MnnLlmChat/README.md

iOS

新增 iOS 的大模型应用,详见 apps/iOS/MNNLLMChat/README.md

新特性

模型支持

支持 Qwen2-VL / Qwen2-Audio / Qwen2.5-VL 等多模态大模型的导出和运行。

支持 DeepSeek-R1-1.5B-Qwen 和 DeepSeek-R1-7B-Qwen

LLM 单步执行支持

新增了对 LLM 单步执行的支持,便于调试和优化模型推理过程。

LLM 扩展采样算法支持

扩展了采样算法的支持,提升了模型推理的灵活性和多样性。

LLM 导出模型时支持输出历史 Token 的概率值

在导出 LLM 模型时,新增了输出历史 Token 概率值的功能,便于后续分析和优化。

LLM-CPU 支持 mmap 文件缓存

新增了对 mmap 文件缓存的支持,使二次加载模型时避免内存重排,提升了加载效率。

性能优化

CPU 多线程性能进一步提升

对 LLM 多线程性能进行了优化,进一步提升了整体推理速度。

CPU prefill 性能优化

优化了 CPU 上 prefill 性能,使 1024 token 输入和 512 token 输入的 prefill 性能持平。

GPU 优化 OpenCL AutoTuning 耗时

优化了 OpenCL AutoTuning 的耗时,避免了首次推理耗时过长的问题。

GPU 优化:Metal / OpenCL 支持 fp16 的 scale/bias,支持对称量化优化

Metal / OpenCL 后端支持 fp16 的 scale/bias 和对称量化优化的支持,提升了推理效率。

LLM 加速:Metal / OpenCL 后端支持 scale/bias 使用 fp16

Metal / OpenCL 支持 scale/bias 使用 fp16(设置 precision = low 时启用),进一步优化了 GPU 推理性能。